Als journalist heb je niet alleen te maken met je eigen verhalen, maar ook met de reacties van je publiek erop. AI helpt Nu.nl om een oogje in het zeil te houden.

Als journalist heb je niet alleen te maken met je eigen verhalen, maar ook met de reacties van je publiek erop. AI helpt Nu.nl om een oogje in het zeil te houden.

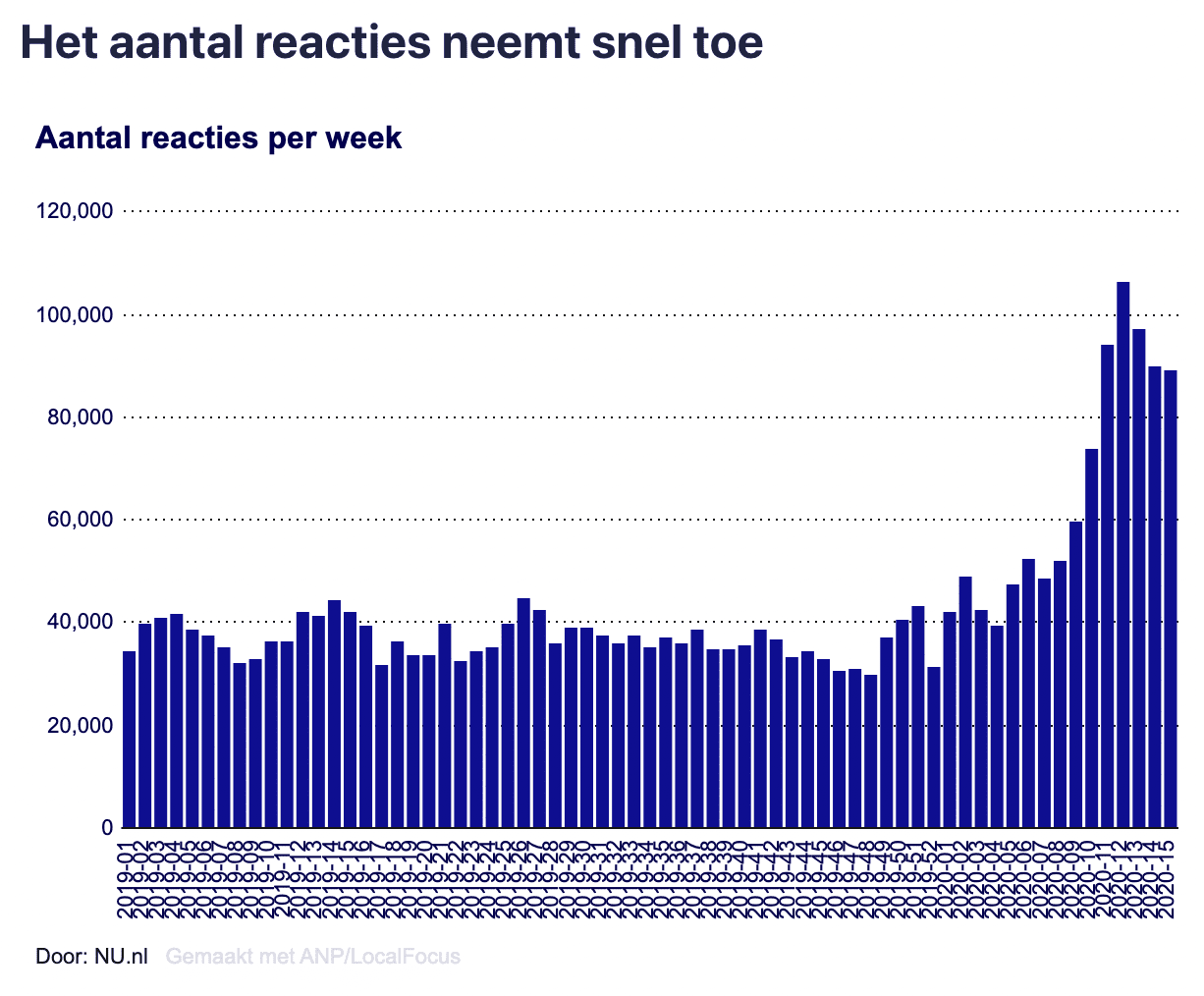

In april 2020 meldt NU.nl dat ze een nieuwe collega hebben: de robot Maura – een afkorting van Machine voor AUtomatisch Reacties Afhandelen. De redactie van NU.nl krijgt zoveel reacties op nieuwsberichten (meer dan 600.000 per maand), dat het niet meer mogelijk is om alle berichten handmatig door redacteuren te laten controleren. Robot Maura zorgt voor een oplossing. Zij voorspelt volgens NU.nl in 80% van de gevallen correct of een reactie wel of niet door de beugel kan volgens de regels van de nieuwssite. De overige 20% van de reacties worden nog altijd door menselijke redacteuren gecontroleerd. Dat scheelt een hoop werk.

Het hele verhaal is hier te lezen.

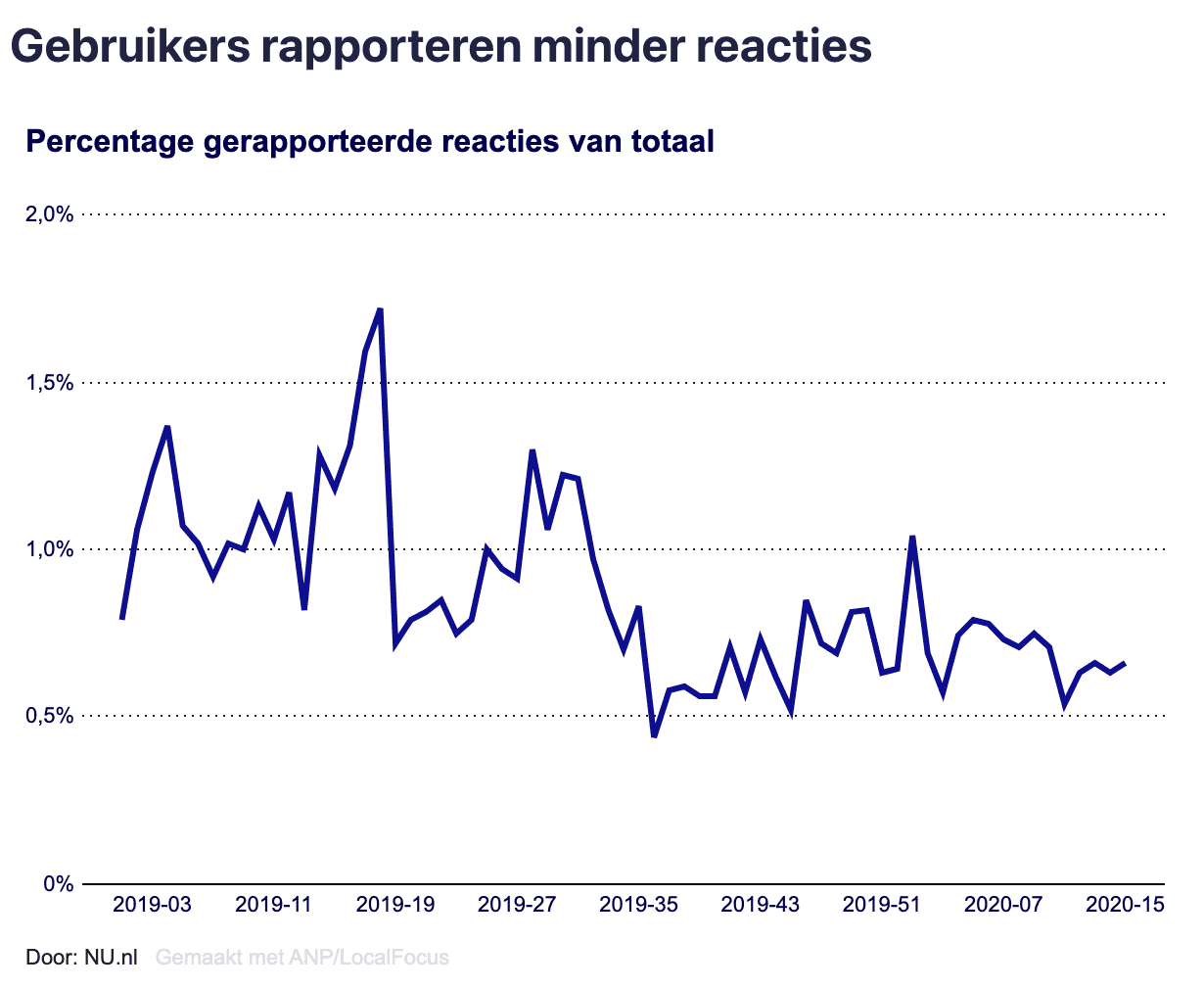

Voor de ontwikkeling van Maura was geen data nodig, omdat er regels worden opgesteld door mensen waaraan het model zich vervolgens simpelweg dient te houden. Nu Maura eenmaal actief is, dienen de reacties van mensen op de site als input voor het systeem om steeds beter te worden. Gebruikers kunnen het namelijk aangeven als een reactie volgens hen niet oké is. Van die informatie leert de machine.

Laten we bij het begin beginnen. Hoe werkt Maura precies? Maura is een voorbeeld van rule-based AI, ofwel: een model dat regels opvolgt. Mensen stellen regels op die bepalen of een reactie van het publiek wel of niet door de beugel kan.

Daarnaast kent Maura ook een aantal harde regels en lijsten met verboden woorden. Het zijn zaken die NU.nl niet tolereert zoals scheldwoorden. Er bestaat daarnaast een grijze lijst waarop woorden staan die in sommige contexten acceptabel zijn, maar in anderen niet. Het woord ‘kanker’ bijvoorbeeld, dat een scheldwoord kan zijn, maar ook kan verwijzen naar de ziekte. Een redacteur geeft per artikel aan welke regels Maura moet opvolgen. In 80% van de gevallen is Maura in staat om op basis van die regels goed in te schatten of een reactie wel of niet binnen de richtlijnenvan NU.nl past. Bij de overige 20% velt een redacteur uiteindelijk het oordeel.

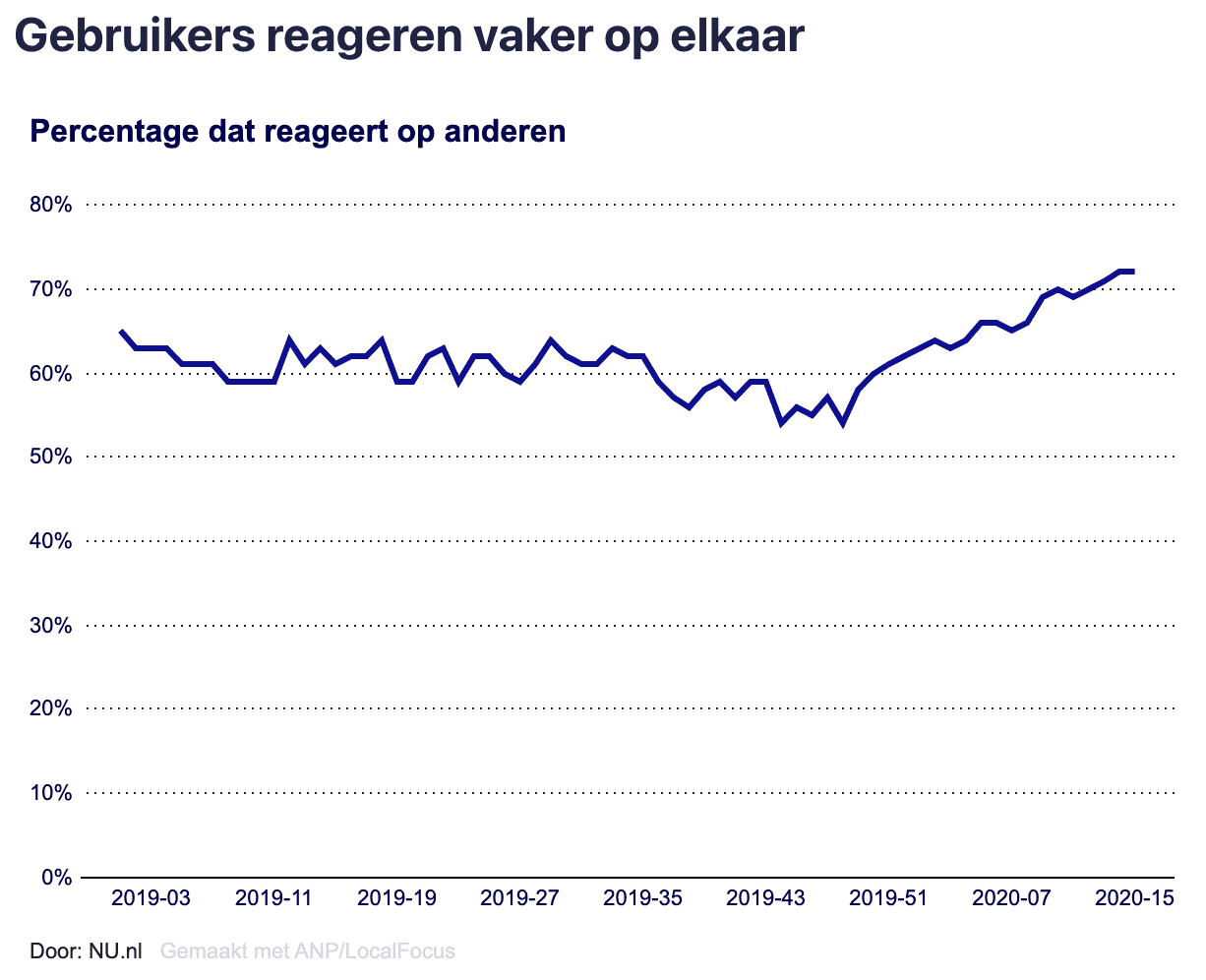

Maura leert vervolgens bij door reinforcement learning. Dat betekent dat de regels van het model steeds nauwkeuriger en accurater worden dankzij menselijke feedback. Gebruikers van de website kunnen reacties aankaarten bij de redactie waarvan zij vinden dat ze niet oké zijn. Dankzij die feedback wordt Maura steeds beter in het inschatten of een reactie de regels overschrijdt of niet.

Het feit dat Maura zich aan regels moet houden die mensen bedacht hebben, betekent dat er een zekere transparantie is. Bij Machine Learning leert AI zelf regels en patronen te ontdekken die mensen soms niet meer kunnen volgen. Dat is anders bij rule-based AI, het type AI waarvan Maura gebruik maakt. Bij rule-based AI hebben menselijke ontwikkelaars nog steeds de leiding. Zij sturen het model aan met de regels die ze bedenken.

Hoewel de werking van het model dus begrijpelijk is voor de makers, geldt dat niet voor het publiek. Want de regels waaraan Maura zich moet houden, zijn niet openbaar. Dat is begrijpelijk, omdat het publiek de machine anders te slim af kan zijn. Als mensen lezen dat ze het woord ‘kanker’ niet als scheldwoord mogen gebruiken, maar dat de machine het niet herkent als scheldwoord wanneer ze het schrijven als ‘k4nker’, wordt het erg makkelijk voor mensen om de regels te omzeilen.

Hoewel het gebrek aan publieke transparantie dus begrijpelijk is, maakt dit het model ook vatbaar voor bias. Het feit dat mensen de regels voor dit model opstellen, maakt dat er vooroordelen in kunnen sluipen. De (onbewuste) vooroordelen die mensen hebben, kunnen immers worden doorgegeven via de regels waaraan de machine zich moet houden. De kans daarop wordt nog groter wanneer de regels worden bedacht door een groep ontwikkelaars die weinig divers is.

Omdat we de regels van Maura niet kunnen inzien, is het onduidelijk of bijvoorbeeld het taalgebruik van bepaalde groepen sneller wordt gekenmerkt als ‘niet oké’, dan het taalgebruik van andere groepen. Wat vindt Maura er bijvoorbeeld van als er straattaal wordt gebruikt? Dat weten we niet.

project van Hogeschool Utrecht

gemaakt door Wilfred Hoogendoorn

contactinformatie

Heb je ideeën of voorbeelden voor deze website of wil je samenwerken?

Neem contact op via

journalistiek-en-ai @journalismlab.nl

Ik wil..