We beginnen dit verhaal met een video.

Zie je hier iets geks aan? Gezien de titel van deze webpagina vermoed je misschien al iets. Deze journalist, Nick Kivit, spreekt geen woord Oekraïens en toch lijkt hij de taal in deze video vloeiend te beheersen.

Het is, wat je noemt, een deepfake. De originele video was namelijk zo:

Met behulp van deepfake liet Nick Kivits zijn oproep naar het Oekraïens vertalen, omdat hij op zoek was naar Oekraïense journalisten. Hij verwacht dat zijn bereik en impact groter zijn als hij zijn vakgenoten in hun eigen taal aanspreekt.

Nick Kivits is niet de enige journalist die zich bezighoudt met deepfakes. Ook met het verschijnen van de tv-serie ‘Welmoed & de sexfakes’ (NPO Start, november 2022) laaide het publieke debat rondom deepfake video’s weer op. De presentatrice komt erachter dat ze in een deepfakepornofilm speelt, die schrikbarend echt lijkt. Ze besluit op zoek te gaan naar de daders.

De roep om een verbod op deepfakes klonk eind 2022 steeds luider. Maar niet iedereen is het daarmee eens, want deepfakes bieden ook kansen aan makers en journalisten:

De Nederlandse politie zette een deepfake in om ooggetuigen op te roepen.

De Correspondent maakte de Mark Rutte-deepfake ‘Het eerlijke klimaatverhaal’.

Zowel rapper Kendrick Lamar als Nike gebruikten deepfake-technologie om een videoclip en commercial te maken.

Om een eenvoudige deepfake te maken heb je niet zo gek veel materiaal nodig. Je moet een video hebben met daarin de persoon wiens gezicht je wilt gebruiken en een video met de persoon wiens gezichtsuitdrukkingen je wilt overnemen.

Met de vrije toegang tot deepfaketechnologie wordt het steeds makkelijker om op een overtuigende manier audio- en videomateriaal te manipuleren of vanuit het niets te genereren. Je hebt geen (stem)acteurs meer nodig, geen speciale pakken en geen montageruimte of studio om nepvideo’s te maken.

Maar snel en eenvoudig realistische deepfakes maken valt in de praktijk nog tegen. Je hebt er anno 2023 veel voor nodig: geduld, ervaring met verschillende beeldbewerkings- en montagesoftware en technische kennis.

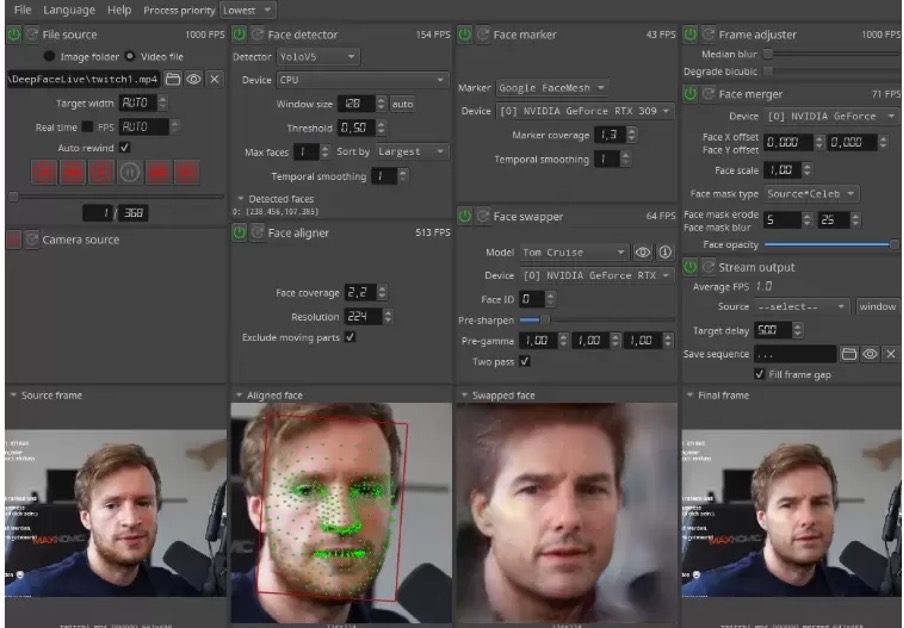

Wel zijn er ondertussen diverse tools om zelf deepfakes mee te maken. Deze tools maken allemaal weer gebruik van verschillende technologieën en programma’s om tot het eindresultaat te komen. We zoomen in op DeepFaceLab.

DeepFaceLab

Om met dit programma een deepfake te maken, heb je ten minste twee video’s nodig: van het gezicht dat je wil gebruiken en van de gezichtsuitdrukkingen die je wil overnemen. Uit deze video’s worden beelden gegenereerd waarop de software vervolgens de contouren van het gezicht herkent en andere belangrijke punten zoals de ogen, de mond en de neus.

Zodra deze voorbereiding is voltooid begint het trainen van het model. In verschillende rondes wordt de video steeds beter gemaakt tot het zo goed mogelijk lijkt op een combinatie van de originele video’s: het gezicht uit de ene video en de gezichtsuitdrukkingen en bewegingen uit de andere video.

In deze video legt de maker van een deepfake ooggetuigenoproepvideo van de politie uit hoe hij te werk is gegaan

Voor de nieuwsgierige journalist

Wil je dit zelf eens proberen zonder iets te installeren, google dan op DeepFaceLab en gebruik de Google Colab Notebook die op de DeepFaceLab-site wordt aangeboden. Door in die notebook een-voor-een alle stappen te doorlopen kun je met eigen beeld een deepfake maken.

Let op: je hebt er een Google-account, Google Drive-opslag, de juiste video’s, programmeerkennis en heel veel geduld voor nodig.

Met deze toepassing kun je gezichten wisselen. Het is daardoor niet voor alle scenario’s bruikbaar. Met DeepFaceLive (alleen voor Windows) kun je live je gezicht in videobeelden ‘swappen’ (omzetten) naar een gezicht van een ander.

De deepfake is nog verre van volwassen. Bij de inzet ervan voor journalistieke doeleinden zijn zowel redacties, het publiek en de ‘acteurs’ in de deepfakes gebaat bij transparantie over de totstandkoming, verantwoording en de beoogde doelen.

Het maken en bestrijden van deepfakes is naast een juridische en ethische kwestie ook een technologische wapenwedloop geworden. Het wordt aan de ene kant steeds eenvoudiger om deepfakeste creëren, anderzijds komen er steeds meer tools om ze te detecteren. Nederlandse bedrijven als FairFake en DuckDuckGoose, en internationale bedrijven als Deepware.ai en Sensity.ai bouwen detectoren om gemanipuleerde video’s te analyseren en herkennen.

Ernst-Jan Pfauth waarschuwde onlangs in zijn NRC-column ‘Golf van kunstmatige bagger’voor generatieve AI en deepfakes. Hij ziet vooral negatieve gevolgen van deze toepassingen. Een daarvan is dat het een gevaarlijk nieuw wapen is in de handen van mis- en desinformatiemakers. Pfauths betoog komt op het volgende neer: als het nu al zo makkelijk is om online onwaarheden te fabriceren, verspreiden en/of versterken over een bepaald persoon of bepaalde organisatie of rondom een fenomeen of gebeurtenis, dan wordt dat met de visuele overtuigingskracht van generatieve AI alleen nog maar erger. Ook hij haalt de serie van tv-presentatrice Welmoed Sijtsma aan, waarin ze de wereld van de deepfakevideo verkent. Volgens Pfauth kun je als je bekend bent, zoals Welmoed, je podium gebruiken om de misinformatie over jezelf te debunken. Maar als je onbekend bent (en dat is waarschijnlijker), sta je machteloos als iemand een deepfake van je maakt.

Deepfakes stellen ons voor een morele kwestie: wanneer en waarom zou je een dergelijke video maken van een klasgenoot of BN’er en deze online publiceren of doorsturen via WhatsApp of delen in een Telegram-groep? Welke fakes zijn fair en constructief en welke niet? Dat is iets wat we met iedereen in de samenleving moeten bespreken.

Over wetgeving en handhaving

Wetgeving voor de aanpak van schadelijke, synthetische content (waar deepfakes onder vallen) is in de maak. Soms blijken bestaande wetten, zoals de AVG, ervoor te zorgen dat mensen berecht kunnen worden als ze deepfakes kwaadwillend inzetten.

Wat achterblijft, is de handhaving van dit soort wetten, zeggen onderzoekers van Tilburg University. Het Rathenau Instituut stelt: ‘Het blijkt voor slachtoffers van deepfakes op dit moment heel moeilijk om daders te achterhalen, of platforms te verzoeken video’s offline te halen, zelfs wanneer die in strijd zijn met het portretrecht of AVG. Burgers moeten dan ook beter geholpen worden om hun recht te halen. Het is belangrijk dat er wetgeving komt die platforms verplicht een adequate klachtenprocedure in te richten en onrechtmatige content te verwijderen. Ook is gerichte wetgeving nodig om slachtoffers te beschermen. Net zoals ze dat bij de AVG deed, zou de Europese Unie hierin het voortouw kunnen nemen.’ De onderzoekers uit Tilburg schatten dat het momenteel bij meer dan 95% van alle deepfakes gaat om zogenoemd non-consensual porn – zoals in Welmoed en de Sekstapes. Het is bekend dat de verspreiding van dergelijke video’s een zeer grote impact kan hebben op het privéleven, de maatschappelijke positie en het zelfbeeld van slachtoffers. Twee nieuwe wetten – de AI Act en de Digital Services Act – zouden bedrijven kunnen verplichten om deepfakes te labelen zodat ze op te sporen zijn.

Deepfakes zijn een nieuwe stap in de media-evolutie. Ze vragen ons om na te denken over de vraag wat manipulatie is. Vroeger dacht men dat fotografie de schilderkunst overbodig zou maken. De intrede van Photoshop zou manipulatie van beeld in de hand werken. Met de opkomst van de deepfake moeten we opnieuw met elkaar beslissen wat we acceptabel en geloofwaardig vinden.

project van Hogeschool Utrecht

gemaakt door Wilfred Hoogendoorn

contactinformatie

Heb je ideeën of voorbeelden voor deze website of wil je samenwerken?

Neem contact op via

journalistiek-en-ai @journalismlab.nl

Ik wil..