AI kan veel. Ook zelfstandig de tekst van een hele podcastaflevering schrijven. Sinds ChatGPT op de markt is, kijken we er niet meer van op. Maar hoe werkt dat eigenlijk en wat betekent het voor journalisten?

AI kan veel. Ook zelfstandig de tekst van een hele podcastaflevering schrijven. Sinds ChatGPT op de markt is, kijken we er niet meer van op. Maar hoe werkt dat eigenlijk en wat betekent het voor journalisten?

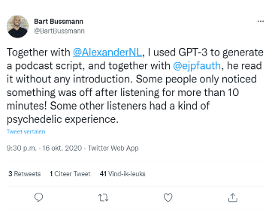

Met de aflevering Onze Stokpaardjes, van Podcast Over Media, is iets bijzonders aan de hand. De gehele aflevering werd namelijk geschreven door AI. Daarvoor werkte Alexander Klöpping (oprichter van Blendle) en Ernst-Jan Pfauth (oprichter De Correspondent) samen met AI-onderzoeker Bart Bussmann, die op Twitter beschrijft wat er gebeurde:

“Sommige mensen hadden pas na meer dan tien minuten luisteren door dat er iets aan de hand was. Andere luisteraars hadden een soort psychedelische ervaring. Hun brein probeerde te snappen wat voor quasi-nonsens de presentatoren zeiden, maar voor ze het daadwerkelijk konden verwerken, werd er alweer iets anders surrealistisch gezegd.”

De tekst van de aflevering mocht grammaticaal dan wel kloppen, maar inhoudelijk was er geen touw aan vast te knopen. Het was het werk van AI.

De aflevering is een experiment van de twee makers, die in hun podcast hun licht schijnen op media, technologie, cultuur en ondernemen. In plaats van over technologie te praten, besloten de twee in deze aflevering uit te proberen wat er gebeurt als je AI aan het roer zet.

Om AI de tekst voor de podcast te laten bedenken, voedden de journalisten het AI-model met de scripts van alle eerdere afleveringen. Er waren al 150 afleveringen gemaakt, die de journalisten als input gebruikten.

Omdat het gebruikte algoritme het beste werkt op Engelstalige teksten, zijn de scripts eerst vertaald met behulp van Google Translate.

Wanneer je tekst laat bedenken door AI, dan noemen we dat Natural Language Generation (NLG). Voor het genereren van het podcastscript is gebruik gemaakt van GPT-3, een zeer groot taalmodel, dat is ontwikkeld door het bedrijf OpenAI – tegenwoordig vooral bekend van ChatGPT.

Wat je vooral moet weten, is dat het GPT-3 Taalmodel is gevoed met miljarden teksten dat het overal en nergens van het web heeft geschraapt. Welke teksten precies? Daarover bestaan alleen vermoedens. Precieze informatie heeft (behalve de medewerkers van OpenAI) niemand, toegang tot de onderliggende data evenmin.

Als je als mens een tekst wil schrijven, moet je eerst in staat zijn om teksten te kunnen verwerken en begrijpen. Je moet het alfabet kennen, weten wat een letter is, een woord en vervoegingen en hoe zinnen worden opgebouwd. Bij AI werkt dat net zo. Om een computer tekst te laten genereren moet het tekst eerst kunnen verwerken. Het neemt bestaande teksten als input. Dat noemen we Natural Language Processing (NLP). Vervolgens moet het systeem ook begrijpen waar die tekst over gaat, wat er in staat. Dat noemen Natural Language Understanding (NLU). Het herkennen van entiteiten (mensen, plaatsen, organisaties) of sentimenten (verontwaardiging, sarcasme, blijdschap) in teksten zijn typische NLU-taken.

Je kunt een taalmodel ook gericht trainen door het te voeden met relevante teksten. Door dat bijtrainen met eigen tekstdata kun je GPT-3 nog beter benutten voor heel specifieke taken, zoals het schrijven van een smartlap, marketingcontent of podcastscripts. De Correspondent trainde het model bij met de 150 eerder opgenomen afleveringen van POM.

Op basis van deze informatie kon het model zelf een tekst schrijven. Dat heet Natural Language Generation.

Deep Learning

Voor het ontwikkelen van GPT-3 is gebruik gemaakt van Deep Learning, een complexe variant van Machine Learning. We leggen het verschil tussen Deep Learning en Machine Learning uit aan de hand van een simpel voorbeeld.

Stel, je wil een systeem leren om het verschil tussen honden en katten te herkennen. Als je gebruik maakt van Machine Learning, biedt je het model eerst foto’s aan waarbij je aangeeft of het om een hond of een kat gaat. Dat zijn de labels. Je geeft zoveel voorbeelden met labels, tot het model in staat is om patronen te herkennen en zo zélf honden en katten te onderscheiden op nieuwe afbeeldingen.

Bij Deep Learning bied je het systeem alléén de foto’s aan, zonder het label ‘hond’ of ‘kat’. Op basis van enkel data (bijvoorbeeld de honden- en kattenfoto’s) ontdekt een Deep Learning AI-systeem zelfstandig patronen en regels. Om dat te kunnen, maakt DL gebruik van neurale netwerken. Ingewikkeld? Dat valt wel mee. Bekijk onderstaande video’s maar eens.

Zoals de luisteraars van POM al merkten, genereert GPT-3 een script dat realistisch klinkt, maar waar inhoudelijk weinig van klopt. Een taalmodel kan teksten genereren die grammaticaal kloppen, en een logische vorm en stijl hebben, maar waarvan de informatie onjuist of zelfs onzinnig is.

Laat je GPT-3 bijvoorbeeld een recept genereren, dan ziet het resultaat er op het oog realistisch uit, maar blijkt er ruim honderd gram zout bij de ingrediënten van een koekjesrecept te staan. Als een taalmodel een journalistiek artikel zou genereren, kan hier ook onzin in staan. Of het artikel is grotendeels kloppend, maar bevate toch enkele essentiële fouten.

Een taalmodel als GPT-3 is in de praktijk een black box: het is voor de gebruiker compleet onduidelijk waar het model zich op baseert, en waarom er een bepaald resultaat uitkomt. Als gebruiker heb je daar dus ook geen controle over. Een ander probleem is dat het model voornamelijk gebaseerd is op dat waar het internet veel van heeft: Noord-Amerikaanse, witte data. De kans op bias is daarmee groot.

Bovendien roept het gebruik van bestaande teksten, vragen op rondom auteursrecht. Elke tekst is in feite geplagieerd, ook al bestaat het bronmateriaal uit duizenden teksten. Ook bij de resulterende teksten, is onduidelijk bij wie het auteursrecht ligt. Is dat de ontwikkelaar van het algoritme, is dat de gebruiker, of misschien zelfs het algoritme zelf? In de Verenigde Staten heeft het US Copyright Office in februari 2022 bepaald dat een kunstwerk dat door AI is gegenereerd, geen auteursrechten kent, omdat er geen sprake is van een menselijke auteur. Zou hier hetzelfde moeten gelden?

project van Hogeschool Utrecht

gemaakt door Wilfred Hoogendoorn

contactinformatie

Heb je ideeën of voorbeelden voor deze website of wil je samenwerken?

Neem contact op via

journalistiek-en-ai @journalismlab.nl

Ik wil..